L’inarrêtable course à la performance des serveurs

Les serveurs accompagnent l’adoption d’usages de plus en plus gourmands en ressources. Indispensables pour orchestrer l’accès au cloud, ils gonflent leur puissance face à l’essor de l’IA.

Mar 2024Par Frédéric Bergonzoli

Les serveurs sont exploités depuis longtemps pour héberger des applications, stocker des données, exécuter de multiples processus métier, virtualiser des environnements et mettre en scène toutes sortes de scénarios dans lesquels s’impose le cloud.

Du simple serveur au bare metal, de l’appliance au data center, choisir le bon matériel fait toute la différence dans la réussite d’un projet. Les serveurs partagés sont économiques, mais relativement lents et sujets à des baisses de performances s’ils sont trop sollicités. Plus traditionnels, les serveurs dédiés présentent des performances élevées mais des coûts de gestion accrus, tandis que les serveurs virtualisés offrent les mêmes avantages mais à moindres frais. Les serveurs cloud présentent une grande évolutivité, au détriment d’une configuration initiale complexe. Quant aux serveurs bare metal, ils conjuguent hautes performances et excellentes capacités d’évolution. Ils sont cependant plus onéreux.

Le marché foisonne de systèmes modulaires, flexibles, tout-terrain, prêts à l’emploi ou taillés sur mesure, qui profitent d’avancées technologiques.

« L’achat d’un serveur cloud implique de connaître les scénarios d’utilisation »

Mathieu Morel, chef produit chez Asus France

Choisir son serveur

Les fabricants de puces AMD, Intel et Arm sont les principaux acteurs de ces améliorations, sans parler de Nvidia dont les GPU raflent la mise dans le domaine des solutions d’infrastructures dédiées à l’IA. Les progrès sont fulgurants, et la puissance des machines semble ne connaître aucune limite. Pour autant, les critères de choix de ces serveurs apparaissent presque immuables. « Il faut commencer par déterminer le type de workload ciblé, car les besoins en charges de travail diffèrent d’un point de vue matériel.

La puissance des processeurs, leur nombre de cœurs et leur capacité à basse consommation permettent de cibler plusieurs types de workloads. Néanmoins, les offres ne peuvent se passer d’innovations.

D’abord en termes d’agilité avec une gestion as a service du matériel, comme le fait la plate-forme Green Lake : elle automatise l’environnement de calcul, que le serveur soit à la périphérie ou dans le cloud. Ensuite, au niveau de la sécurité, en encryptant une clé dès la conception du serveur dans une approche silicon root of trust. Enfin, le volet environnemental est essentiel. Il doit tenir compte de la conception des machines dans un circuit d’économie circulaire et de l’optimisation de leur cycle de vie », indique Jérôme Riboulon, directeur des ventes et préventes de la BU Serveur chez HPE.

« L’achat d’un serveur cloud implique une connaissance des scénarios d’utilisation, des performances et une puissance de calcul recherchées, de la connectivité réseau nécessaire et du budget. Les critères de choix pour un serveur cloud dédié IA, par exemple, sont en priorité la densité du serveur, le GPU supporté et sa configuration, la connectivité, sans oublier le nombre d’utilisateurs prévu par serveur », ajoute Mathieu Morel, chef produit chez Asus France.

« La responsabilité environnementale fait l’objet d’une prise de conscience de la majorité des acteurs et des clients »

Sébastien Verger, CTO France de Dell Technologies

Des performances innovantes

L’irrésistible évolution des puces de calcul s’étend aux autres composants matériels, en particulier le stockage avec la banalisation du SSD et la consolidation du MVMe, et, plus généralement, la réduction des formats des disques. La pile logicielle n’est pas en reste.

Un acteur tel qu’Oracle, qui n’est à l’origine pas un fabricant, a su, par le biais du rachat du constructeur Sun à la fin des années 2000, concevoir des serveurs exclusivement destinés à ses bases de données. Chez ce fournisseur hybride, les critères de choix d’une infrastructure demeurent la performance, la fiabilité, l’évolutivité et la sécurité. « La puissance est un critère lié aux puces. Combinée avec une intelligence logicielle, elle atteint des niveaux de performance inégalés. La fiabilité repose sur des mécanismes de redondance interne liés aux composants matériels et qui permettent de maintenir le service en cas de panne. L’évolutivité est la capacité d’ajouter des composants au fil de l’eau pour accompagner de nouveaux besoins en puissance de calcul ou en stockage pendant le cycle de vie d’une solution », explique Samuel Noblot, directeur Cloud@Customer Sales EMEA South chez Oracle.

Si la capacité de traitement des charges de travail doit se montrer efficace, le serveur est également évalué sous l’angle de son coût par watt. La densification des serveurs, qui réduit l’espace d’hébergement et simplifie le câblage, n’a d’intérêt que si la chaleur générée est correctement dissipée. « Que l’on parle de densité, de puissance calorifique ou de puissance électrique, les notions environnementales font l’objet d’une prise de conscience d’une majorité d’acteurs et de clients qui veulent réduire leur impact. À cela s’ajoute l’augmentation du prix de l’énergie, qui favorise la recherche

de solutions moins consommatrices, tant pour faire fonctionner le serveur que refroidir son environnement.

Se pose la question d’opter pour un refroidissement à air, exploité en majorité dans les centres de données, ou liquide, avec un direct liquid cooling plus efficace. Or, certains data centers ne peuvent être refroidis avec un circuit d’eau, ce qui, au regard de l’augmentation de puissance des traitements et la nécessité d’optimiser la densité au mètre carré, peut être un obstacle. On voit apparaître des technologies d’immersion encore plus performantes mais qui demandent une adaptation des serveurs », indique Sébastien Verger, CTO France de Dell Technologies.

Les constructeurs se disent concentrés sur tous ces points pour répondre à la grande variabilité des projets. Et ce, avec l’appui de leur channel, notamment des MSP, chargés d’assurer le déploiement des solutions.

« En partant du besoin de nos clients en termes de sécurité, de performances, de consommation carbone et de fiabilité, nous avons bâti non seulement une architecture serveur mais aussi une architecture globale adaptée. Avec l’idée de proposer une grande variété d’offres, que l’on soit dans le monde Intel, mainframe ou quantique. Certes, l’ordinateur quantique disponible sur le cloud IBM ne correspond pas encore aux besoins de la majorité de nos clients. Mais nous sommes préparés à ces besoins, depuis les serveurs simples jusqu’au quantique, en passant par l’IA », assure Mehdi Arafa, manager des architectes IBM Cloud.

Plus de la moitié des organisations françaises voient dans la technologie une réponse aux enjeux environnementaux et sociaux

Dans neuf pays dont la France, Fujitsu a interrogé en novembre dernier 1 800 organisations des secteurs privé et public sur leur connaissance et leur expérience de la transformation durable et numérique. La France se montre la plus sensible à cet enjeu avec 16 % des entreprises sondées (contre 8 % en moyenne pour les autres pays) capables de monter des stratégies de développement durable matures, et dont certaines fournissent déjà des résultats. Environ 52,5 % d’entre elles estiment que les technologies permettront d’améliorer la fiabilité des données et de visualiser la valeur environnementale et sociale (contre 47,8 % à l’échelle mondiale).

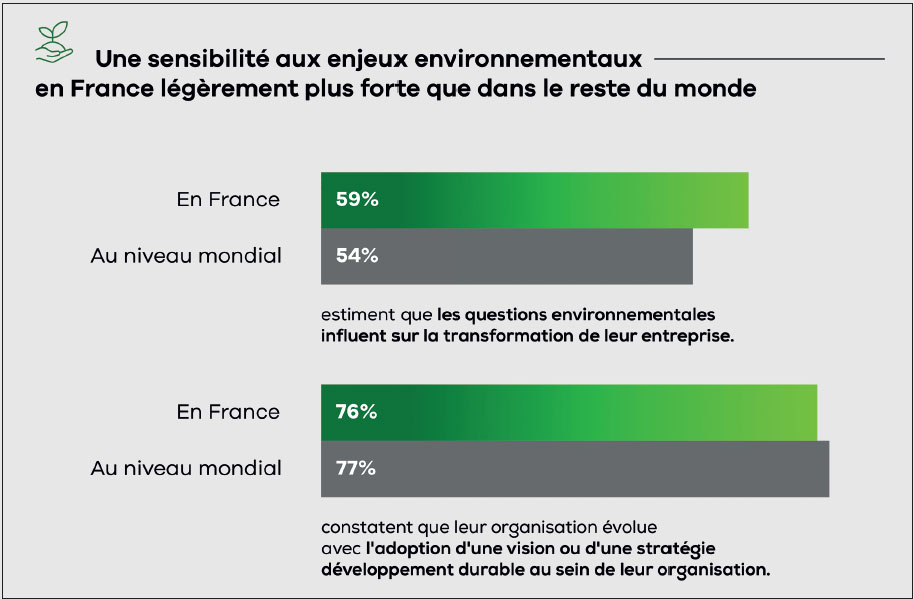

Elles sont d’ailleurs 55,5 % à penser que, d’ici à 2030, cette valeur sera évaluée sur de nombreux produits et diffusée dans la société pour promouvoir la durabilité. Autres informations de cette enquête, 59 % des entreprises françaises estiment que les questions environnementales influent sur la transformation de leur organisation, et elles sont 76 % à voir la politique de leur organisation évoluer avec l’adoption d’une vision ou d’une stratégie de développement durable. Plus concrètement, 56 % des personnes interrogées considèrent que leur organisation doit pouvoir contribuer à l’augmentation des capacités humaines et à développer l’automatisation grâce à l’IA afin d’y améliorer la productivité et l’expérience des employés. De leur côté, 49,5 % souhaitent que leur organisation génère de l’innovation en utilisant des ordinateurs haute performance ainsi que de l’IA pour accélérer les processus d’innovation. Selon Fujistu, au cours des cinq prochaines années, 67,5 % des organisations françaises augmenteront leurs investissements en priorité sur l’IA. Elles sont même 47,4 % à positionner cet investissement en priorité absolue.