La French touch face aux géants de l’IA

La tech française s’est emparée de l’IA et de tous ses enjeux avec des fournisseurs bien installés et des start-up qui tentent de tirer leur épingle du jeu dans un marché dominé à 70 % par les Gafam.

Déc 2024Par Jérôme Dard

Ce visuel a été généré par le créateur d’images Bing.

Juste derrière les Gafam, OVHcloud et Orange sont les deux seuls acteurs français à être positionnés comme des major players dans le rapport « IDC MarketScape: European Public Cloud IaaS 2024 Vendor Assessment », publié en octobre dernier (voir ci-contre).

« Contrairement aux géants américains, OVH bénéficie d’une immunité aux lois extraterritoriales, permettant une gestion des données respectueuse des réglementations européennes, souligne d’emblée Gilles Closset, Global AI Ecosystem Leader au sein d’OVHcloud. Nous assurons à nos clients que leurs données restent les leurs et qu’elles ne sont jamais exploitées à leur insu. Toutes nos offres sont souveraines by design. »

L’hégémonie américaine du cloud se confirme

Le rapport d’IDC confirme la domination des géants américains sur le marché du cloud public IaaS stratégique pour l’IA. Deux acteurs français, Orange et OVH, parviennent à tirer leur épingle du jeu.

Source : IDC, 2024

Parmi les autres facteurs différenciants mis en avant par la marque, l’écoresponsabilité est au cœur de l’ADN d’OVHcloud, qui vient de fêter les 20 ans de son système de water cooling réduisant de 35 % la consommation d’eau de ses centres de données. Côté offre, le spécialiste français de l’hébergement et du cloud fournit une gamme de GPU Nvidia Tensor Core (H100, A100, L4, L40S) accessibles dans le cloud public et de modèles IA de pointe avec l’intégration des derniers LLM open source, tels que Mixtral 8x22B ou Llama3, qui sont notamment disponibles sur étagère via la solution sans serveur OVHcloud AI Endpoints. Le produit phare est le fameux H100, « la Rolls des GPU actuellement », explique Gilles Closset, qui souligne être en mesure de « le distribuer à la demande à des prix très compétitifs en mode as a service ». En complément, le directeur de l’écosystème IA évoque des GPU comme

les A100, L4, L40S, qualifiées de « plus petites et un peu plus anciennes, qui permettent d’avoir exactement le bon ratio prix-puissance ».

Les partenaires peuvent piocher dans deux grandes familles de solutions : le catalogue des différentes briques des outils AI avec AI Notebook, AI Training et AI Deploy. L’autre solution, qui s’adresse à des développeurs, des start-up, des clients finaux, « AI Endpoint », propose des catalogues de modèles as a service (Mistral, Nvidia, Llama…). Interrogé sur les différents types de partenariats possibles autour de l’IA, Gilles Closset précise les trois niveaux proposés. Celui foisonnant de start-up, qui a vu répondre plus de 5 000 jeunes pousses depuis sa création et pour lequel est annoncé pour janvier 2025 un nouveau programme spécifique baptisé « AI Accelerato ». Un deuxième niveau d’accompagnement est disponible à travers le programme « Open Trusted Cloud » aux membres de l’écosystème IT, notamment aux partenaires de type éditeurs de logiciels et fournisseurs de solutions SaaS et PaaS, qui peuvent « bénéficier à la fois d’un accompagnement technique et marketing et des valeurs de souveraineté et d’écoresponsabilité, à intégrer à leur discours commercial et marketing », souligne Gilles Closset. Le dernier niveau de coopération est dédié au channel, avec le programme Partenaires classique pour les sociétés de conseil, les intégrateurs et autres MSP.

« Dans ce programme, les partenaires sont formés sur les solutions, soutenus pour optimiser leur workload d’IA et aidés pour se positionner par rapport aux autres acteurs. »

Nous distribuons le H100 à la demande, la Rolls des GPU, à des prix compétitifs en mode as a service. »

Gilles Closset, Global AI Ecosystem Leader au sein d’OVHcloud

Le mariage de l’infrastructure et de l’interface

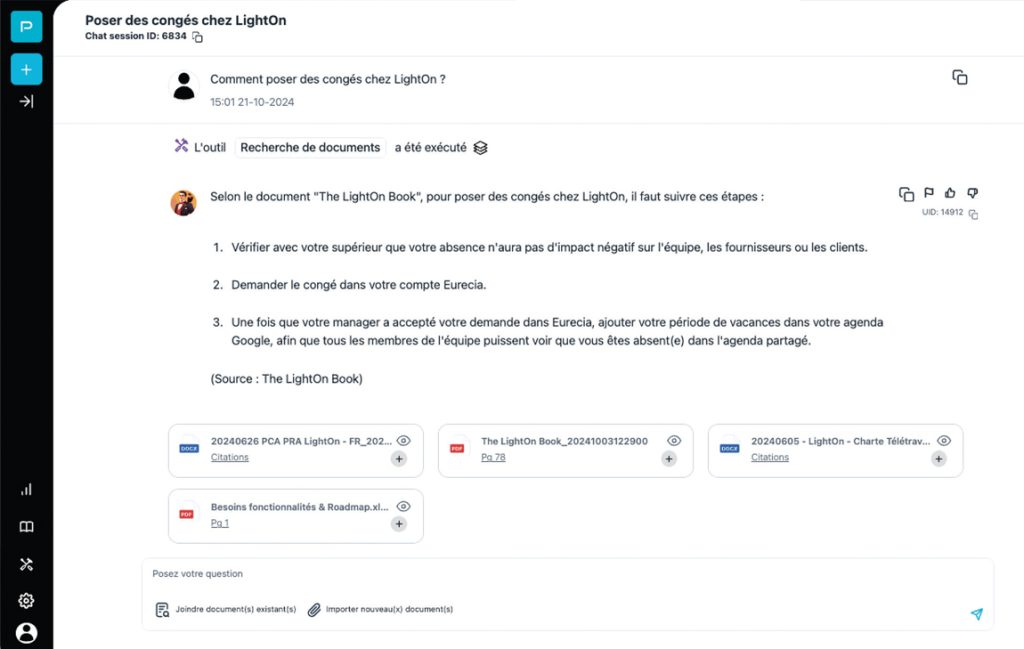

« Nous avons lancé cette année deux nouvelles offres d’IA générative de confiance pour permettre aux entreprises du CAC 40 et du tissu industriel régional d’accéder à l’IA de manière simple sans pour autant avoir besoin de compétences avancées et d’IA scientists », explique Alexandre Bord, directeur Cloud France d’Orange Business. Une offre de GPU as a service (H100 et L40S) pour l’entraînement de modèles et l’inférence, et une offre SaaS clés en main d’IA générative proposée avec son partenaire LightOn et son produit phare d’IA générative : Paradigm (voir encadré). « L’interface homme-machine [IHM] Paradigm fait la différence.

Nous avons été séduits par la légèreté de son moteur LLM adapté à la plupart de nos clients et qui atteint les niveaux de moteurs les plus réputés avec une moindre consommation énergétique. » L’opérateur historique, qui annonce vouloir « accompagner ses clients au-delà du buzz », reste sur une stratégie de distribution interne et, via des partenariats stratégiques avec des start-up, semble avoir trouvé son go to market en 2024 : « Nous avons signé différentes commandes d’une valeur de plusieurs millions d’euros depuis le mois de mars », souligne le directeur Cloud France d’Orange Business, qui indique s’être doté de capacité de plusieurs centaines de GPU et évoque un travail de réflexion en cours pour incorporer un certain nombre d’autres partenaires éditeurs et leur permettre d’utiliser également l’offre de GPU Cloud Avenue.

« Pour nous, c’est une façon de déployer l’IA générative sans avoir géré la partie hardware. Ça nous fait monter vers la vente indirecte en marque blanche, confirme Benoît Bouffard, directeur produits, marketing et média de LightOn. Nous avons fait le choix de proposer des outils aux entreprises pour qu’elles puissent déployer leur propre GPT interne. Notre angle c’est le privacy. »

À moins d’un an de l’application stricte du cadre réglementaire européen sur l’intelligence artificielle, l’AI Act, et dans un contexte de tensions accrues autour des ressources hydriques et électriques pour les data centers, au delà de la « ruée vers l’offre », l’écosystème tech a intérêt à faire évoluer ses critères d’achat vers des IA génératives sobres et sans concession sur la souveraineté des données.

La start-up LightOn en phase avec Orange

Paradigm, l’offre phare de LightOn, repose sur trois grandes briques : GPT simple, RAG Chat with doc (capacité qu’un utilisateur interagisse avec sa base documentaire) et industrialisation de workflows plus complexes (par exemple, répondre à un appel d’offres). La licorne, créée en 2016, a développé plusieurs LLM (large language models), dont Alfred-40B-0723, un modèle open source qui exploite l’apprentissage par renforcement à partir de commentaires humains pour effectuer des tâches complexes, telles la synthèse de contenu, la réponse aux requêtes et l’ingénierie des prompts. « Nous proposons des outils aux entreprises pour qu’elles puissent déployer leurs propres GPT internes. Notre angle, c’est le privacy. »

La start-up, qui vient d’annoncer un partenariat stratégique avec Channel Tools, le confirme : « Que vous soyez un intégrateur, une entreprise de conseil ou un autre partenaire potentiel, vous pouvez exploiter et revendre la technologie d’IA générative de Paradigm. »

L’interface de Paradigm, développée par LightOn, permet via l’IA générative de gérer les demandes d’utilisateurs en liaison avec les ressources documentaires de l’entreprise, par exemple ici les RH pour les congés.